Tecnología

¿La revolución de las IA ha comenzado? No, pero un trabajador de Google asegura que una inteligencia artificial de la empresa tomó consciencia propia

Uno de los ingenieros de Google ha sido suspendido y acusado de violar las políticas de confidencialidad de la empresa después de que diera a conocer su preocupación por el hecho de que uno de los sistemas de IA hubiera conseguido desarrollar la sensibilidad

Según The Washington Post, el ingeniero Blake Lemoine, que trabaja en la parte de Inteligencia Artificial de Google, estaba probando si el modelo LaMDA utilizaba discursos discriminatorios o de odio, y mientras hablaba de religión con el sistema, se dio cuenta de que el chatbot también abordaba cuestiones sobre sus derechos y su personalidad, opinando incluso sobre la tercera ley de la robótica de Isaac Asimov.

Ya en abril, Lemoine había expresado sus preocupaciones a los ejecutivos en un documento llamado “¿Es MDA sensible?”, que incluía una transcripción de sus conversaciones con la IA, que publicó en Medium una vez que fue suspendido, con argumentos de que la Inteligencia tenía sentimientos, emociones e incluso experiencias subjetivas.

Google consideró que las acciones relacionadas con su trabajo en LaMDA habían violado las políticas de confidencialidad de la empresa, según TWP, ya que llegó a realizar una serie de movimientos “agresivos”, como invitar a un abogado para que representara a la IA y hablar con un representante del Comité Judicial de la Cámara de Representantes sobre lo que consideraba actividades poco éticas de la empresa.

¿Es posible que las inteligencias artificial tomen consciencia propia?

El portavoz de Google, Brian Gabriel, comentó con TWP que no tiene sentido considerar la posibilidad de una IA sintiente antropomorfizando los modelos conversacionales actuales que no tienen esa capacidad, ya que sólo imitan los intercambios encontrados en millones de frases.

Gabriel añadió que incluso ha habido conversaciones con LaMDA por parte de investigadores e ingenieros y que hasta ahora nadie ha hecho las mismas afirmaciones ni ha antropomorfizado el sistema de la misma manera que Blake.

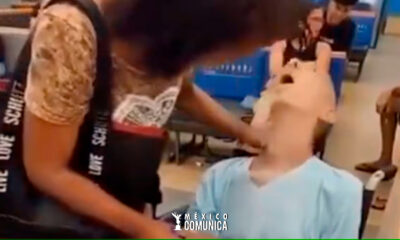

MexicoHace 7 días

MexicoHace 7 díasHAMBREADA LLEVA EL CUERPO SIN VIDA DE UN SEÑOR PARA PODER PEDIR UN PRESTAMO ECONOMICO EN BRASIL

MexicoHace 1 día

MexicoHace 1 díaCARTIER PIERDE MILES DE DOLARES POR ERROR Y NO QUIERE HACERSE RESPONSABLE DE SUS ACTOS !!!!! SE ENCUENTRA EN UNA FUERTE DEMANDA CON PROFECO

MexicoHace 1 día

MexicoHace 1 díaNO LE DURO NI 30 MINUTOS SU PRIMER AUTO